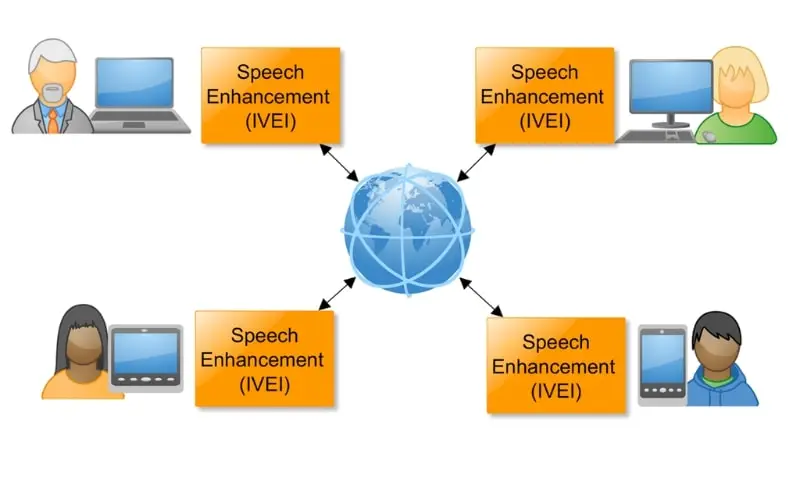

Zespół pod kierownictwem Pana dra. hab. inż. Konrada Kowalczyka, prof. AGH (Instytut Elektroniki) pracuje nad specjalistycznym wielomikrofonowym systemem, który pozwoli na zarejestrowanie naszej mowy i odpowiednie jej przetworzenie bez względu na miejsce przebywania w pomieszczeniu czy istniejące zakłócenia. Sieć połączonych ze sobą mikrofonów umożliwi komunikację głosową osobie swobodnie poruszającej się w pomieszczeniu, nie będzie przy tym konieczne użycie słuchawek z mikrofonem czy tradycyjnego pojedynczego systemu głośnomówiącego.

Doskonale znamy z życia sytuacje, gdzie jakość dźwięku słyszanego może być zakłócona poprzez szumy, obce głosy, pogłos, czy wręcz zanik dźwięku w momencie oddalenia się od tradycyjnego mikrofonu. Technologia Intelligent Voice Enhancement Interface (IVEI), nad którą pracują naukowcy z Zespołu Przetwarzania Sygnałów AGH, ma ten problem rozwiązać i pozwoli na prowadzenie naturalnej rozmowy nawet wtedy, gdy mówiący porusza się, oddala od mikrofonów czy nie przebywa w idealnej ciszy.

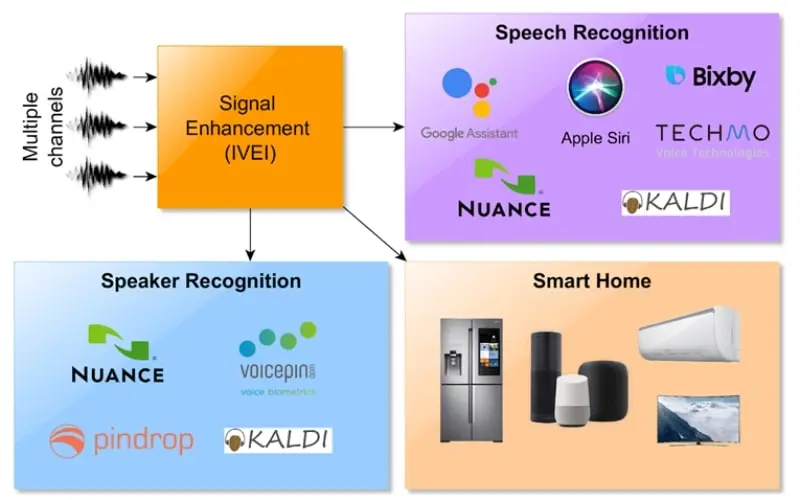

Rozwijana technologia będzie mogła z powodzeniem być stosowana np. w tzw. inteligentnych domach, biurach czy wirtualnej rzeczywistości. Opierają się one często o głosową komunikację człowieka z urządzeniem. Warto podkreślić, że APDAS (Audio Processing using Distributed Acoustic Sensors – Przetwarzanie Dźwięku z wykorzystaniem Rozproszonych Czujników Dźwięku) mogą stworzyć jedną, obejmującą całe pomieszczenie czy dom sieć, która poza głosowym sterowaniem urządzeniami, pozwoli na przykład dokonywać biometrycznej identyfikacji i lokalizacji osób znajdujących się w różnych pomieszczeniach.

„Jednoczesne przetwarzanie sygnałów pochodzących z kilku połączonych ze sobą «inteligentnych» urządzeń wyposażonych w jeden lub więcej mikrofonów umożliwi uzyskanie wyższej jakości sygnału niż w przypadku używanych obecnie pojedynczych, niezależnie pracujących urządzeń. Zaletą takiego rozwiązania będzie możliwość sterowania głosowego nawet na dużą odległość oraz swobodnego korzystania z aplikacji głosowych w chmurze bez konieczności posiadania dedykowanego danej aplikacji sprzętu audio” – podkreśla – dr hab. inż. Konrad Kowalczyk, prof. AGH.

Projekt APDAS realizuje zespół w składzie: dr inż. Stanisław Kacprzak, dr inż. Marcin Witkowski, mgr inż. Szymon Woźniak, mgr inż. Magdalena Rybicka, mgr inż. Julitta Bartolewska, mgr inż. Mieszko Fraś, mgr inż. Mateusz Guzik. Międzynarodowymi partnerami projektu są m.in. naukowcy z Uniwersytetu Johnsa Hopkinsa w USA oraz Uniwersytetu w Walencji w Hiszpanii. Osiągnięcia członków zespołu utworzonego dzięki wsparciu Fundacji na rzecz Nauki Polskiej to m.in. pierwsze i drugie miejsce w międzynarodowych zawodach w przetwarzaniu sygnałów IEEE Signal Processing Cup w 2019 i 2021 roku, gdzie opracowano algorytmy lokalizacji dźwiękowej osób poszkodowanych dla dronów ratowniczych oraz algorytmy automatycznej konfiguracji inteligentnych powierzchni odbijających sygnały w sieciach 6G, jak również stypendium Fulbright Junior Scholarship na roczne badania na Uniwersytecie Johnsa Hopkinsa czy nagroda Prezesa Rady Ministrów przyznana za wybitne osiągnięcia naukowe.

Badania są finansowane przez Fundację na rzecz Nauki Polskiej w ramach programu FIRST TEAM ze środków pochodzących z Funduszy Europejskich z Programu Operacyjnego Inteligentny Rozwój oś IV: Zwiększenie potencjału naukowo-badawczego, Działanie 4.4 Zwiększanie potencjału kadrowego sektora B+R.

Zapraszamy do odwiedzenia strony Zespołu Signal Processing Group.

Artykuł opracowano na podstawie „Bystry słuch komputera. Badania krakowskiego zespołu mogą zmienić to, jak sterujemy naszymi urządzeniami” dostępny TUTAJ.